Mozilla Fondation réduit ses effectifs de 30 % pour se recentrer sur sa mission face aux défis technologiques

La Fondation Mozilla, l'organisme à but non lucratif qui soutient le navigateur Firefox, a récemment annoncé un licenciement de 30 % de ses effectifs, en invoquant une « vague de changements implacable ». Cette restructuration vise, selon Mozilla, à accroître son agilité et son impact face aux défis technologiques actuels.

Crédit image : Mozilla

Crédit image : Mozilla

Interrogé par TechCrunch, le responsable de la communication de la Fondation Mozilla, Brandon Borrman, a confirmé cette réduction de personnel par e-mail.

"La Fondation Mozilla réorganise ses équipes pour devenir plus agile et pour maximiser son impact, alors que nous accélérons nos efforts pour assurer un avenir technologique plus ouvert et équitable pour tous. Cela implique malheureusement la fin de certains projets et la suppression de postes associés, afin de recentrer notre travail pour l’avenir", a-t-il déclaré.

Selon les déclarations fiscales de la Fondation, Mozilla employait environ 60 personnes en 2022. Cependant, au moment de ces licenciements, l’effectif était proche de 120 employés, selon une source anonyme. Mozilla n’a pas contesté ce chiffre.

Il s’agit du deuxième licenciement chez Mozilla cette année, le premier ayant affecté plusieurs employés travaillant sur la partie de l’organisation dédiée au développement du navigateur Firefox.

Mozilla se compose de plusieurs entités, notamment la Mozilla Corporation, qui développe Firefox et d'autres technologies, et la Fondation Mozilla, une organisation à but non lucratif et exonérée d'impôts, qui supervise la gouvernance de l’organisation et oriente ses politiques.

Une grande partie du travail de Mozilla se concentre sur la défense de la vie privée, l’inclusion et la décentralisation des technologies, avec pour objectif de créer des expériences en ligne plus sûres et transparentes, au bénéfice des utilisateurs de Firefox et du public.

Dans un courriel adressé à l’ensemble des employés le 30 octobre, Nabiha Syed, directrice exécutive de la Fondation Mozilla, a confirmé que deux divisions majeures — la défense des droits et les programmes globaux — ne feraient plus partie de la structure de l’organisation.

Après la publication de cette annonce, Brandon Borrman a précisé à TechCrunch que la « défense des droits reste un principe central du travail de la Fondation Mozilla et sera intégrée dans toutes les autres fonctions », sans donner plus de détails.

Cette réorganisation s'inscrit dans la volonté de la Fondation, selon Syed, de produire une « narration unifiée et puissante », en révisant sa stratégie de communication.

"Notre mission chez Mozilla est aujourd’hui plus cruciale que jamais", a écrit Syed dans un e-mail adressé au personnel, dont une copie a été partagée avec TechCrunch.

Nous faisons face à une période de changements constants dans le monde technologique et au-delà, et mettre l'humain avant le profit semble de plus en plus radical.

Elle conclut en soulignant que cette période mouvementée requiert une concentration accrue, ce qui passe parfois par des choix difficiles, y compris l’abandon de certains travaux importants menés jusque-là.

Atteindre des objectifs ambitieux exige des décisions difficiles.

Sources multiples :

Techcrunch

Mozilla blog

Le Monde Informatique

Cet article a été écrit avec un combo IA + bon sens humain.

Parce que l’un sans l’autre, c’est souvent foireux !

Publié le par Technifree

En parler sur le forum

Vers une transparence renforcée pour l’IA open-source en France

Le paysage de l’Intelligence Artificielle évolue rapidement, surtout en matière d'open-source. La définition de ce que signifie réellement l'« IA open source » est au centre des préoccupations de nombreux acteurs, qu’il s’agisse de gouvernements, de chercheurs ou d’entreprises. En France, un tournant décisif vient d’être pris : le Pôle d'Expertise de la Régulation Numérique (PEReN) a lancé un outil innovant pour guider les utilisateurs dans le choix de modèles d’IA, basé sur une grille de critères d’ouverture.

Crédit image : PEReN

Crédit image : PEReN

L'Open Source Initiative (OSI), reconnue pour sa rigueur dans la définition de l’open source, a publié la version 1.0 de sa propre définition de l'IA open source. Inspirée des libertés du logiciel libre, cette définition fixe quatre principes fondamentaux :

- • Liberté d’utilisation : tout utilisateur peut exploiter le modèle pour n'importe quel usage sans demande préalable.

- • Liberté d’examen : les utilisateurs peuvent étudier le modèle pour comprendre ses mécanismes et ses composants.

- • Liberté de modification : les utilisateurs peuvent modifier le modèle à des fins diverses, y compris pour altérer ses résultats.

- • Liberté de partage : les utilisateurs peuvent redistribuer le modèle, avec ou sans modifications, pour n’importe quel usage.

Le comparateur d'ouverture : L'outil du gouvernement pour mieux s’orienter

Face à la complexité croissante de l’IA, le gouvernement français, par le biais du PEReN, a récemment introduit un comparateur d’ouverture des modèles d’IA. Cet outil aide les utilisateurs à choisir des modèles de génération de texte ou d’image en fonction de critères d’ouverture spécifiques. Le comparateur regroupe actuellement 14 modèles textuels et 6 modèles visuels, et permet de trier selon divers facteurs tels que :

- • La possibilité de redistribution du modèle

- • La licence d’usage commerciale

- • Les restrictions éthiques

- • La transparence sur les données d’entraînement et la documentation

Un tableau évolutif et collaboratif

Conçu pour évoluer, le comparateur de PEReN se veut un outil collaboratif, encourageant les utilisateurs et experts à contribuer à son enrichissement. Les critères d’ouverture varient, intégrant des éléments comme la disponibilité des poids du modèle, la publication des articles scientifiques associés, et la transparence de l’infrastructure. Ce tableau est particulièrement utile pour quiconque cherche à évaluer le degré d’ouverture de différents modèles et choisir en fonction de ses besoins.

La gouvernance : un aspect fondamental du développement de l’IA

Au-delà des critères d’ouverture, la question de la gouvernance des modèles open source soulève des débats. Le PEReN met en garde contre les dérives possibles : un modèle open source peut être vulnérable à des pratiques de contrôle par des entreprises dominantes. Par exemple, Android, bien que considéré comme open source, reste sous la domination de Google qui contrôle en partie cet écosystème. Cette situation rappelle la nécessité de surveiller la gouvernance des projets open source dans le domaine de l'IA pour prévenir les dérives monopolistiques, telles qu'on peut le constater un peu partout (vive le capitalisme !).

La définition de l'OSI insiste désormais sur une transparence accrue concernant les données d’entraînement. Une simple description détaillée n'est plus suffisante : l’OSI exige désormais une présentation exhaustive des données utilisées, un point crucial pour garantir l'intégrité et l’éthique dans le développement des modèles. De plus, la méthodologie de filtrage des données doit être documentée et son code publié, une exigence qui marque une avancée vers une meilleure traçabilité des processus d’entraînement.

Une absence de contrainte sur la publication des paramètres du modèle

L’OSI ne souhaite pas pour l’instant imposer de licence spécifique pour la publication des paramètres du modèle. Cette question pourrait se clarifier avec le temps et l’évolution de la législation autour de l'IA open source. En attendant, l’OSI encourage les concepteurs à publier les paramètres de leurs modèles pour favoriser la reproductibilité et la confiance dans les résultats.

Chez Meta on propose un modèle divergent de l’open source

La définition de l’OSI suscite toutefois des tensions, notamment avec Meta, qui revendique le caractère open source de ses modèles LLaMA. Bien que la société affirme partager plusieurs points de vue de l’OSI, elle ne publie pas les données d’entraînement de ses modèles. Cette réticence pose la question de l’équilibre entre l’ouverture et le respect des exigences de transparence.

Malgré certaines divergences, cette nouvelle définition reçoit malgré tout l’adhésion des acteurs du milieu (non, rien à voir avec Frodon). Clément Delangue, PDG de Hugging Face, salue cette avancée comme un jalon important pour renforcer la transparence, en particulier sur les données d’entraînement, ce qui est essentiel pour une IA responsable.

Sommes nous face à une initiative pionnière vers une IA éthique et accessible ? L’avenir nous le dira, mais une chose est sûre : la transparence et l’ouverture sont désormais au cœur des préoccupations de l’écosystème de l’IA open source.

Sources multiples :

NEXT

PEReN

CNRS

HuggingFace

Cet article a été écrit avec un combo IA + bon sens humain.

Parce que l’un sans l’autre, c’est souvent foireux !

Publié le par Technifree

En parler sur le forum

Noyb Porte Plainte Contre Mozilla pour Activation Silencieuse de la Fonction “Privacy Preserving Attribution”

Le 25 septembre 2024, l'organisation noyb (None of Your Business) a déposé une plainte contre Mozilla, accusant le géant technologique d'avoir activé sans consentement une fonctionnalité de confidentialité, nommée “Privacy Preserving Attribution” (PPA), dans son navigateur Firefox. Cette fonctionnalité vise à remplacer les cookies de suivi traditionnels, permettant à Firefox de suivre le comportement des utilisateurs sur les sites web sans que ceux-ci aient à recourir à des cookies tiers.

Crédit image : Noyb

Crédit image : Noyb

Malgré son appellation rassurante, la PPA soulève des préoccupations importantes concernant la vie privée. En effet, alors que Mozilla prétend améliorer la protection des données des utilisateurs, le système permet au navigateur de contrôler le suivi des utilisateurs, remplaçant ainsi les cookies par un mécanisme qui enregistre les interactions publicitaires. Selon Mozilla, cela offrirait une méthode moins invasive de mesure de la performance publicitaire, mais cela ne supprime pas complètement le problème de la collecte de données.

Les utilisateurs n'ont pas été informés de l'activation de cette fonctionnalité, qui a été mise en place par défaut après une récente mise à jour de Firefox. Ce manque de transparence est particulièrement préoccupant pour une entreprise qui a traditionnellement été perçue comme une alternative respectueuse de la vie privée, contrairement aux navigateurs basés sur Chromium de Google.

Un Manque de Consentement

L'activation de la PPA sans le consentement explicite des utilisateurs contredit les principes fondamentaux du Règlement Général sur la Protection des Données (RGPD) de l'Union Européenne. En effet, Mozilla n'a pas inclus cette fonctionnalité dans ses politiques de protection des données, laissant les utilisateurs dans l'ignorance des implications de cette option de suivi. Pour désactiver la PPA, les utilisateurs doivent naviguer dans les sous-menus des paramètres du navigateur, un processus qui ne garantit pas une prise de décision éclairée.

Felix Mikolasch, avocat spécialisé en protection des données chez noyb, critique cette approche :

Mozilla vient d'adhérer à l'idée que l'industrie de la publicité a le droit de pister les utilisateurs en transformant Firefox en un outil de mesure de la publicité. Bien que Mozilla ait pu avoir de bonnes intentions, il est très peu probable que l'”attribution préservant la vie privée” remplace les cookies et autres outils de suivi. C'est une honte qu'une organisation comme Mozilla pense que les utilisateurs sont trop stupides pour dire oui ou non.

Face à cette situation, noyb demande à l'autorité autrichienne de protection des données (DSB) d'enquêter sur le comportement de Mozilla. L'ONG exhorte Mozilla à informer correctement ses utilisateurs sur le traitement de leurs données et à adopter un système d'opt-in plutôt que d'opt-out. De plus, noyb appelle Mozilla à supprimer toutes les données traitées illégalement.

À Propos de Noyb

Noyb est une organisation non gouvernementale basée à Vienne, en Autriche, qui se consacre à l'application des lois sur la protection des données, notamment le RGPD et la directive ePrivacy. Composée d'une équipe de plus de 20 experts juridiques et informatiques, l'ONG œuvre pour garantir le respect du droit fondamental à la vie privée dans le secteur privé.

La plainte de noyb contre Mozilla soulève des questions cruciales sur la transparence et le consentement en matière de protection des données. Alors que la PPA vise à améliorer la vie privée des utilisateurs, son activation par défaut sans consentement pourrait nuire à la confiance que les utilisateurs placent en Mozilla. Dans un monde de plus en plus axé sur la protection des données, les entreprises doivent être vigilantes et respectueuses des droits de leurs utilisateurs.

Sources multiples :

Le journal du Hack

noyb.eu

Cet article a été écrit avec un combo IA + bon sens humain.

Parce que l’un sans l’autre, c’est souvent foireux !

Publié le par Technifree

En parler sur le forum

Une nouvelle catégorie de licence logicielle fait son apparition : « fair source »

Une nouvelle catégorie de licence logicielle, appelée « fair source », a été introduite par la société de logiciel Sentry. Cette initiative bénéficie du soutien de startups telles que Codecov, GitButler, Keygen, PowerSync, Ptah.sh et CodeCrafters. La licence « fair source » vise à combiner les avantages des logiciels propriétaires et des logiciels libres, en répondant aux tensions financières et communautaires qui existent entre ces deux mondes.

Crédit image : fair.io

Crédit image : fair.io

La « fair source » est un paradigme de licence conçu pour faire le lien entre les mondes ouvert et propriétaire. Selon Sentry, cette licence permet aux entreprises de conserver un certain niveau de propriété sur leur code tout en impliquant la communauté des développeurs. Pour être défini comme « Fair Source Software (FSS) », le code doit adhérer à trois principes clés :

• Être lisible publiquement : Le code doit être accessible et lisible par tous, ce qui permet une transparence et une collaboration accrue.

• Permettre l'utilisation, la modification et la redistribution avec un minimum de restrictions : Cela vise à protéger le modèle commercial du producteur tout en permettant une certaine flexibilité pour les utilisateurs.

• Faire l'objet d'une publication Open Source différée (DOSP) : Le logiciel est initialement déployé sous une licence propriétaire avant d'être progressivement transféré vers une licence open source.

Résoudre les tensions entre logiciels propriétaires et logiciels libres

De nombreux développeurs et entreprises ont subi des réactions négatives après avoir abandonné leur licence open source. Par exemple, HashiCorp est passé à une licence propriétaire en 2023, suscitant des critiques de la part de la communauté open source. Le fair source pourrait permettre aux entreprises de conserver un certain niveau de propriété sur leur code sans s'attirer les foudres des développeurs de logiciels libres pour avoir abandonné la communauté.

Sentry explique que l'objectif du fair source est de légitimer la pratique des entreprises qui partagent de manière significative l'accès au code de leurs produits logiciels de base tout en conservant le contrôle de leur feuille de route et de leur modèle commercial. Cependant, des critiques comme Amanda Brock, PDG d'OpenUK, estiment que cette nouvelle licence pourrait ajouter une complexité juridique et freiner l'innovation.

L'open source menacé par le manque de financement

Le développeur Bruce Perens a critiqué les licences ouvertes, affirmant que les développeurs de logiciels open source ont besoin de plus d'incitations financières pour maintenir l'écosystème en vie. Il a déclaré que rémunérer les développeurs de manière équitable pour leur travail est essentiel. Le développeur Jan Kammerath a également déploré le manque de financement et de compréhension de l’open source de la part des organisateurs de l’initiative, qui attendent que la communauté open source mette en œuvre leurs concepts gratuitement, sans leur offrir aucun soutien ni récompense.

La nouvelle licence proposée par Sentry aspire à offrir aux développeurs une liberté sans permettre l’exploitation commerciale non autorisée par des concurrents. Mais certains experts soulignent que le fair source pourrait ajouter une couche de complexité juridique et peut-être même freiner l’innovation.

Sources multiples :

Developpez.com

fair.io

Cet article a été écrit avec un combo IA + bon sens humain.

Parce que l’un sans l’autre, c’est souvent foireux !

Publié le par Technifree

En parler sur le forum

Google perd un procès antitrust majeur mais prévoit de faire appel

Google a récemment perdu un important procès antitrust aux États-Unis, une décision qui pourrait profondément affecter ses pratiques commerciales et l'architecture de l'internet. Le jugement rendu par le juge Amit P. Mehta du tribunal de district de Columbia a conclu que Google avait agi de manière illégale pour maintenir son monopole sur la recherche en ligne.

Le juge Mehta (rien à voir avec la société d'Elon Musk, hein) a déterminé que Google a abusé de sa position dominante en payant des entreprises comme Apple, Samsung ou encore Mozilla pour que son moteur de recherche soit celui par défaut sur leurs appareils et navigateurs. Cette pratique aurait empêché d'autres moteurs de recherche de se développer et de rivaliser équitablement avec Google.

Les chiffres clés

• En 2021, Google a dépensé 26 milliards de dollars pour s'assurer que son moteur de recherche soit le choix par défaut sur les plateformes Apple et Android.

• De cette somme, environ 18 milliards de dollars ont été versés à Apple.

• Google partage également 36% des revenus publicitaires générés par les recherches effectuées via Safari avec Apple.

Les arguments des parties

Le gouvernement américain : Le ministère de la Justice américain et plusieurs États ont intenté une action en justice contre Google en 2020, affirmant que les paiements effectués par Google pour être le moteur de recherche par défaut avaient entravé la concurrence. Ils ont soutenu que ces accords ont empêché des moteurs de recherche comme Bing et DuckDuckGo de collecter les données nécessaires pour améliorer leurs services et rester compétitifs.

Google : De son côté, Google affirme que ses pratiques sont légitimes et qu'elles ont permis d'améliorer la qualité de son moteur de recherche, ce qui profite aux consommateurs et aux annonceurs. Kent Walker, président des affaires mondiales de Google, a déclaré que la société prévoit de faire appel de la décision. Il soutient que Google a gagné la confiance des utilisateurs en fournissant un moteur de recherche de la meilleure qualité qu'il soit.

Les implications du jugement

La décision du juge Mehta pourrait obliger Google à modifier fondamentalement sa manière de faire des affaires. Les remèdes possibles incluent des changements dans la manière dont Google gère ses accords de recherche ou la vente de certaines parties de son entreprise. Cette affaire pourrait également avoir un impact sur d'autres procès antitrust en cours contre des géants de la tech comme Apple, Meta et Amazon.

Google a indiqué son intention de faire appel de cette décision. Le verdict final pourrait donc évoluer, comme ce fut le cas avec le procès antitrust contre Microsoft dans les années 1990. À cette époque, Microsoft avait été reconnu coupable de pratiques monopolistiques, mais l'ordonnance de démantèlement initiale avait été annulée en appel. Toutefois, Microsoft avait dû se conformer à certaines restrictions pour promouvoir la concurrence.

Ce jugement contre Google marque peut-être un tournant majeur dans la régulation des géants de la technologie et pourrait redéfinir les règles du jeu pour les entreprises dominantes dans le secteur numérique, allez, on y croit !

Sources multiples :

Techcrunch

LMI

France24

Cet article a été écrit avec un combo IA + bon sens humain.

Parce que l’un sans l’autre, c’est souvent foireux !

Publié le par Technifree

En parler sur le forum

L'Arcep propose de faire un pas vers un futur plus vert

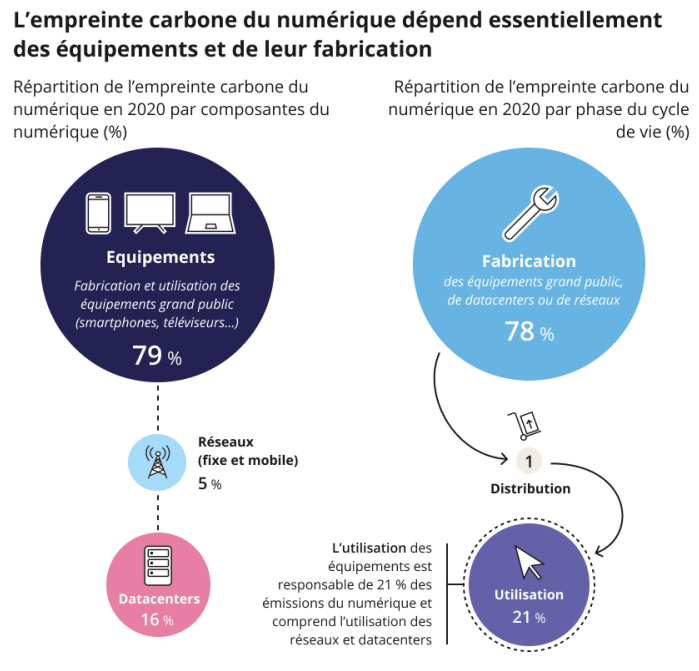

Vous avez probablement entendu parler de l'impact environnemental des technologies de l'information et de la communication (TIC). Eh bien, accrochez-vous, car les chiffres sont impressionnants. Le secteur des TIC représente à lui seul environ 4% des émissions mondiales de gaz à effet de serre, et ces émissions pourraient tripler en France d'ici 2050 si rien n'est fait. L'Arcep (Autorité de Régulation des Communications Electroniques, Postales et de la distribution de la presse en France), est sur le coup avec des propositions concrètes pour réduire cet impact.

Crédit image : Arcep

Crédit image : Arcep

Les appareils électroniques en général :

Les appareils, comme les smartphones et les ordinateurs, sont les principaux responsables de cette empreinte carbone. Mais ce n'est pas tout : les TIC consomment également des métaux (lourds, rares, etc.) et des minéraux, de l'eau, et génèrent des déchets électroniques. Pour réduire cette empreinte, l'Arcep propose trois grandes mesures :

1 - Lutter contre l'obsolescence logicielle : En assurant un support à long terme des systèmes d'exploitation des ordinateurs, on peut prolonger leur durée de vie. Imaginez ne plus avoir à changer votre ordinateur tous les deux ans parce que le système d'exploitation n'est plus supporté !

2 - Adopter une approche globale de l'écoconception : Les services numériques, comme les applications, doivent aussi être pris en compte. Après tout, ils nécessitent des appareils, des réseaux et des centres de données pour fonctionner, et tout cela consomme de l'énergie et des ressources.

3 - Étendre les exigences d'écoconception et d'étiquetage énergétique à d'autres produits numériques : Les routeurs et les boîtiers décodeurs, par exemple, consomment beaucoup d'électricité. En les incluant dans les réglementations, on peut réduire leur impact environnemental.

L'obsolescence logicielle :

Saviez-vous que les ordinateurs représentent 22% de l'empreinte carbone numérique en France ? Et que la phase de fabrication des appareils, des centres de données et des réseaux représente près de 80% de cette empreinte ? L'obsolescence logicielle est l'une des raisons pour lesquelles nous changeons si souvent nos appareils. Pour y remédier, l'Arcep propose que les fabricants et distributeurs d'ordinateurs assurent la maintenance des systèmes d'exploitation pendant 10 ans après la fin de la commercialisation des appareils. Cela permettrait de prolonger la durée de vie des ordinateurs, de réduire les déchets électroniques et de limiter la consommation de ressources.

Les services numériques :

Les services numériques, comme les applications, jouent un rôle crucial dans l'empreinte environnementale des TIC. Ils nécessitent des appareils, des réseaux et des centres de données pour fonctionner, et tout cela consomme de l'énergie et des ressources. L'Arcep propose donc d'inclure les services numériques dans les réglementations d'écoconception. Cela permettrait de prolonger la durée de vie des appareils, d'optimiser les ressources nécessaires pour les services numériques, et d'encourager une plus grande transparence environnementale.

Les Routeurs et les Boîtiers Décodeurs :

Les routeurs et les boîtiers décodeurs consomment beaucoup d'électricité. En 2022, ils ont consommé 3,3 TWh en France, soit plus de trois fois la consommation des réseaux fixes. En incluant ces appareils dans les réglementations d'écoconception et d'étiquetage énergétique, on peut réduire leur consommation d'énergie et leur impact environnemental.

L'Arcep propose des mesures concrètes pour réduire l'impact environnemental des TIC. En luttant contre l'obsolescence logicielle, en adoptant une approche globale de l'écoconception et en étendant les exigences d'écoconception et d'étiquetage énergétique à d'autres produits numériques, nous pouvons tous contribuer à un avenir plus vert. Alors, prêts à faire un pas vers un numérique plus durable ?

Sources multiples :

LaFibre.info

Arcep-dossier du 27/07/2024 (US)

Arcep-Pour un numérique soutenable (pdf)

Cet article a été écrit avec un combo IA + bon sens humain.

Parce que l’un sans l’autre, c’est souvent foireux !

Publié le par Technifree

En parler sur le forum

Un avenir Open Source comme solution viable ?

L'incident récent impliquant Crowdstrike a paralysé une grande partie du monde, mettant en lumière une vérité déplaisante : notre dépendance quasi aveugle aux services des géants de la tech. Ma petite analyse rapide face à cette fatalité.

Crédit image : Fidget @2001

Crédit image : Fidget @2001

En voyant les faiblesses de Windows - ses mises à jour incertaines, ses innombrables bugs, et sa politique de plus en plus lucrative et complexe - ne serait-il pas temps pour les entreprises et les particuliers de se tourner vers des alternatives open source ? Est-il vraiment sensé de continuer cette hémorragie financière et l'utopie de sécurité promise par Microsoft, ou devrions-nous envisager des solutions comme Linux ?

Windows : un géant aux pieds d'argile

Microsoft Windows, bien qu'omniprésent, présente des failles béantes. Prenons l'exemple de la mise à jour d'octobre 2018 de Windows 10, qui a provoqué la perte de fichiers personnels pour de nombreux utilisateurs. Ajoutons à cela les vulnérabilités critiques plus récentes, comme celles exploitées par WannaCry en 2018, le ransomware Conti en 2022, ou encore les failles PrintNightmare et ProxyLogon, qui ont été largement médiatisées et utilisées par des cybercriminels pour prendre le contrôle à distance des systèmes. Il est clair que les solutions propriétaires de Microsoft ne sont ni aussi sûres ni aussi fiables qu'elles le prétendent.

L'Open Source, une alternative viable

L'open source offre depuis bien longtemps une alternative robuste, fiable et flexible. Linux, par exemple, est un système d'exploitation open source reconnu pour sa sécurité et sa fiabilité. Les distributions telles que Red Hat et Debian sont utilisées par des entreprises du monde entier pour leur capacité à offrir des solutions personnalisables sans les contraintes des logiciels propriétaires. Contrairement à Windows, Linux n'est pas sujet aux mêmes types de failles de sécurité critiques, et les correctifs sont souvent déployés plus rapidement grâce à une communauté de développeurs passionnés et compétents.

La Souveraineté Numérique : un enjeu crucial pour la France

La souveraineté numérique est devenue un sujet brûlant en Europe. La France, malgré ses efforts, dépend encore largement de Microsoft pour ses infrastructures. Cette dépendance pose des questions de sécurité et de confidentialité des données (Voir le rapport de la CNSP (AVIS N°2023-06 DU 12 SEPTEMBRE 2023 SUR LA SOUVERAINETE NUMERIQUE). Selon un rapport de Mediapart, la France continue de renouveler ses contrats avec Microsoft pour ses administrations, malgré les préoccupations croissantes concernant la protection des données et la souveraineté numérique.

Aujourd’hui, trois géants américains détiennent 65% du marché du cloud mondial : Amazon Web Services (AWS) à hauteur de 32%, Microsoft Azure à hauteur de 23% et Google Cloud pour 10%.

Les entreprises françaises, elles aussi, se tournent massivement vers des solutions cloud comme AWS, Azure et Google souvent sans considérer les alternatives plus sécurisées et localisées. Pourtant, il existe des solutions européennes qui respectent les normes de sécurité et de confidentialité, telles que OVHcloud ou Scaleway (et non, ce ne sont pas des liens sponsorisés, j'men fous !).

L'exemple Allemand et sa police à la mode linux

L'Allemagne a pris des mesures audacieuses en matière de souveraineté numérique. L'année dernière, la police allemande de la région du Schleswig-Holstein a décidé de se passer de Microsoft sur leurs postes de travail, optant pour des solutions open source comme linux et la suite bureautique LibreOffice Cette transition a permis de renforcer la sécurité tout en réduisant les coûts. Selon ZDNet, cette initiative montre qu'il est possible de fonctionner efficacement sans dépendre des produits propriétaires de Microsoft.

Indépendant, durable, sûr : Le Schleswig-Holstein sera une région pionnière en matière de numérique et le premier État allemand à introduire un poste de travail informatique numériquement souverain dans son administration. Avec la décision du cabinet d'introduire le logiciel libre LibreOffice comme solution bureautique standard, le gouvernement a donné le feu vert à la première étape vers une souveraineté numérique complète dans le Land, avec d'autres étapes à suivre.

Des solutions concrètes et rééalisables

Pour les entreprises et les particuliers cherchant à faire la transition vers l'open source, voici quelques étapes concrètes :

Évaluer les besoins : Identifiez les logiciels propriétaires utilisés et recherchez leurs équivalents open source. Par exemple, remplacez Microsoft Office par LibreOffice ou Google Drive par Nextcloud (je ferai un de ces 4 un article sur les alternatives viables, promis !).

Planifier la transition : Une migration vers l'open source doit être soigneusement planifiée. Commencez par les applications les moins critiques pour tester la compatibilité et la fonctionnalité, sur des environnements de tests ou pour les particuliers, en effectuant des tests sur des machines virtuelles.

Former les utilisateurs : Investissez dans la formation pour que vos employés soient à l'aise avec les nouvelles applications. De nombreux cours en ligne et tutoriels sont disponibles gratuitement.

Implémenter progressivement : Ne passez pas à l'open source du jour au lendemain. Adoptez une approche progressive pour minimiser les perturbations. Parlez de votre expérience, faites en part autour de vous, au sein des communautés

Soutenir la communauté : Contribuez à la communauté open source pour renforcer les solutions que vous utilisez. Signalez les bugs, participez aux forums et, si possible, contribuez au développement et au financement des projets.

La dépendance aux services des GAFAM et les faiblesses des systèmes propriétaires comme Windows mettent en évidence les risques d'une telle centralisation du pouvoir technologique. L'open source offre une voie vers l'autonomie numérique, réduisant les coûts et améliorant la sécurité. La transition vers Linux et d'autres solutions open source pourrait bien être la meilleure décision stratégique pour toute entreprise ou particulier souhaitant se libérer de l'hémorragie financière et de l'utopie de sécurité offertes par Microsoft (ou même Apple, qui ne sort pas spécialement du lot non plus, malgré les apparences parfois trompeuses).

Alors, la prochaine fois que votre Windows se fige au beau milieu d'une présentation importante, pensez à Linux. Non seulement vous pourriez sauver votre journée, mais aussi votre portefeuille et, certainement, votre santé mentale.

Sources multiples :

FranceTVinfo : l'incident Crowdstrike

The Enterprisers project

ZDNet - passer de Windows à linux

Cet article a été écrit avec un combo IA + bon sens humain.

Parce que l’un sans l’autre, c’est souvent foireux !

Publié le par Technifree

En parler sur le forum

Le Cyberdico de l'ANSSI où comment déchiffrer le jargon de la cybersécurité !

Voici un outil qu'il est bien (voir indispensable) pour tous ceux qui veulent comprendre et maîtriser le langage de la cybersécurité : le Cyberdico de l'ANSSI ! Préparez-vous à décrypter les mystères du vocabulaire informatique.

Crédit image : ANSSI

Crédit image : ANSSI

Le Cyberdico, kézako ? Imaginez un dictionnaire spécialement conçu pour vous aider à naviguer dans la jungle des termes techniques liés à la sécurité informatique. Créé par l'Agence nationale de la sécurité des systèmes d'information (ANSSI), cet outil gratuit est là pour vous éclairer sur les mots et expressions qui peuplent l'univers de la cybersécurité.

Vous vous demandez quelle est la différence entre un "malware" et un "virus" ? Vous avez toujours rêvé de comprendre ce que votre collègue informaticien raconte pendant ses interminables monologues sur les "pare-feu" et les "clés de chiffrement" ? Le Cyberdico est fait pour vous !

Grâce à ses définitions claires, accessibles et précises, en français et leur correspondance en anglais, ce dictionnaire (pdf) vous permettra de devenir un véritable expert en sécurité du numérique et des technologies de l'information (non, je déconne, mais au moins, vous comprendrez certain d'entre-eux). Et en plus, il est mis à jour régulièrement pour suivre l'évolution constante des vocabulaires utilisés. Plutôt pratique, non ?

En bref, le Cyberdico de l'ANSSI est l'allié indispensable des curieux et des passionnés qui souhaitent approfondir leurs connaissances et se familiariser avec le langage parfois complexe de la cybersécurité. Alors n'hésitez plus et foncez découvrir cet outil, pour briller dans la société des geeks et vous aider à vous protéger un peu mieux des menaces numériques, ou au moins, en comprendre leur définition !

Et rappelez-vous, dans le monde du numérique, la connaissance et la vigilance sont vos meilleures armes ! Alors, à vos claviers, et que le Cyberdico soit votre allié vers la maîtrise de la cybersécurité !

Source :

ANSSI

Cet article a été écrit avec un combo IA + bon sens humain.

Parce que l’un sans l’autre, c’est souvent foireux !

Publié le par Technifree

En parler sur le forum

Le contrôle parental devient obligatoire sur tous les appareils connectés

À partir du 13 juillet 2024, tous les appareils connectés commercialisés en France devront proposer une fonctionnalité de contrôle parental. Cette nouvelle obligation, issue de la loi Studer votée en mars 2022, vise à mieux protéger les mineurs des contenus inappropriés.

Crédit image : Pixabay

Crédit image : Pixabay

Aujourd'hui, on va parler d'un sujet qui concerne tous les parents et tous les geeks : le contrôle parental. À partir du 13 juillet 2024, les fabricants de matériels connectés en France devront proposer une fonctionnalité de contrôle parental sur leurs appareils. C'est la loi Studer, votée en mars 2022, qui l'impose pour protéger les mineurs de l'exposition aux écrans.

Le but de cette loi, c'est d'informer les parents sur les outils existants pour protéger leurs enfants. Les fabricants, distributeurs et vendeurs d'appareils connectés devront donc respecter de nouvelles obligations en matière de contrôle parental. Ces obligations entreront en vigueur le 13 juillet 2024. C'est une étape importante pour la protection des mineurs, mais attention, ça ne remplace pas la vigilance des parents !

L'Agence nationale des fréquences (ANFR) a publié un rapport en mars 2024 pour guider les fabricants dans la mise en place de cette nouvelle législation. Alors, comment ça marche ?

Lors de la première mise en service de l'appareil, le dispositif de contrôle parental doit être proposé à l'utilisateur. L'idée, c'est d'attirer l'attention des parents sur l'existence de ce dispositif et de les inciter à l'activer immédiatement. La loi précise aussi que les données personnelles des mineurs collectées lors de l'activation du contrôle parental ne doivent pas être utilisées à des fins commerciales, même après leur majorité.

Les appareils concernés devront inclure un dispositif de contrôle parental gratuit, facile d'accès et compréhensible. Ce dispositif permettra au minimum de bloquer le téléchargement et l'accès à certains contenus susceptibles de nuire aux mineurs. Ces contenus sont ceux interdits aux mineurs ou régis par la loi du 17 juin 1998 relative à la prévention et à la répression des infractions sexuelles ainsi qu'à la protection des mineurs. Le dispositif permettra aussi de bloquer l'accès aux contenus préinstallés relevant des mêmes catégories.

Attention, les obligations ne concernent que les contenus installés ou téléchargeables via les boutiques d'applications logicielles. Les sites internet sont donc exclus du champ des contenus à bloquer (Jean-Kevin est content, il pourra toujours faire croire qu'il a 18 ans sur Youporn).

Quels sont les équipements concernés ? Tous les appareils qui permettent de naviguer sur internet et qui disposent d'un magasin d'applications sont concernés. Cela inclut les ordinateurs, les smartphones, les tablettes, les télévisions connectées, les montres connectées, les systèmes de navigation embarqués, les consoles de jeux et les liseuses.

Les équipements terminaux d'occasion mis sur le marché avant le 13 juillet 2024 ne seront pas soumis aux obligations. Cependant, les opérateurs qui les commercialisent devront informer les acheteurs de l'existence de dispositifs de contrôle parental pouvant être installés. Les équipements terminaux d'occasion mis sur le marché après le 13 juillet 2024 seront soumis aux mêmes obligations que les équipements terminaux neufs.

Et si les fabricants ne respectent pas ces obligations ? L'ANFR pourra mettre en demeure le fabricant ou l'opérateur économique concerné de mettre les appareils en conformité ou de les retirer du marché. Si les produits ne sont pas mis en conformité, l'ANFR pourra ordonner leur retrait temporaire et/ou leur rappel du marché national. L'ANFR pourra aussi prononcer une amende administrative de 1 500 € pour une personne physique et 7 500 € pour une personne morale (15 000 € si plusieurs manquements sont constatés).

L'idée est certes intéressante mais elle aurait dû être propagée aux sites internet proposant des contenus sensibles !

Source :

ServicePublic.fr

Cet article a été écrit avec un combo IA + bon sens humain.

Parce que l’un sans l’autre, c’est souvent foireux !

Publié le par Technifree

En parler sur le forum

Les communs numériques et la souveraineté : comment sauver les logiciels libres ?

La souveraineté numérique menacée par la domination des multinationales : les communs numériques et les logiciels libres comme alternatives.

https://laviedesidees.fr/ - BANE ©Felicitas Heyerick

https://laviedesidees.fr/ - BANE ©Felicitas Heyerick

Communs numériques ... souveraineté ... kekséksa ?

Les communs numériques font référence aux ressources numériques partagées et gérées de manière collective par une communauté d'utilisateurs, telles que les logiciels libres, les données ouvertes, les contenus créatifs sous licence libre, etc. Ces ressources sont souvent créées et maintenues par des communautés de contributeurs bénévoles ou rémunérés, qui collaborent de manière ouverte et transparente pour les développer et les améliorer.

La souveraineté numérique, quant à elle, désigne la capacité d'un État à exercer son autorité et son contrôle sur ses ressources numériques, ses infrastructures réseau et ses données, afin de garantir son autonomie et sa sécurité dans le cyberespace. Elle implique également la capacité à protéger les droits fondamentaux des citoyens dans l'environnement numérique, tels que la vie privée, la liberté d'expression et le droit à l'information. La souveraineté numérique est devenue un enjeu majeur pour les États, en raison de l'importance croissante du numérique dans tous les aspects de la vie sociale, économique et politique, et de la menace que représentent les cyberattaques et l'ingérence étrangère dans les affaires intérieures.

Du coup, ça fait quoi ?

Avec la seconde révolution informatique des années 1960, le développement numérique d'un pays repose sur un équilibre fragile entre l'expertise des institutions publiques et l'externalisation de la production des outils par les entreprises. Cependant, avec la mondialisation du marché numérique, cet équilibre a été rompu, laissant place à une concentration des grandes multinationales, principalement américaines. Cette situation a réduit les marges de manœuvre pour assurer la souveraineté numérique, qui consiste en la possibilité pour un État d'assurer son autonomie en matière de ressources logicielles, d'infrastructure réseau et de valorisation des données numériques.

Face à cette situation, le logiciel libre et open source est souvent présenté comme une alternative crédible, offrant davantage de transparence, de sécurité et de confiance. Cependant, malgré les parts de marché croissantes du "marché de l'open source", la plupart des logiciels domestiques, des applicatifs métiers et des systèmes d'exploitation vendus avec les machines sont propriétaires, y compris dans la fonction publique. De plus, la question de la souveraineté numérique ne se limite plus aux usages individuels, mais concerne également le stockage des données et leur localisation, ainsi que la contribution significative au code libre ou open source pour ensuite en extraire toute la plus-value sur des marchés fermés et hégémoniques.

Les multinationales et leurs plateformes ont réussi à marginaliser les alternatives communautaires en mettant en avant la simplicité d'utilisation, la maintenance "clé en main" et l'intégration de leurs produits propriétaires. Bien que les États européens aient pris des engagements en faveur du logiciel libre et open source depuis les années 1990, ils peinent encore à concrétiser leurs discours, notamment dans les marchés publics. Pourtant, la souveraineté numérique est de plus en plus associée au potentiel du logiciel libre ou open source, comme autant de ressources communes dont l'adaptabilité aux besoins permet aux États de développer ou faire développer leurs propres outils numériques, en toute indépendance.

Le prix à payer est celui de l'effort et du savoir-faire dans le développement. Les logiciels libres ou open source sont créés de manière collaborative par des communautés, contributeurs utilisateurs et développeurs, à dimension locale ou mondiale, pour répondre à leurs propres besoins. Ils le font dans une logique économique qui s'oppose à la logique propriétaire des grands éditeurs privés, ce qui n'empêche pas ces derniers de contribuer à leur tour, selon leurs motivations. Certains rares logiciels libres sont issus de la fonction publique, même s'il arrive souvent que cette dernière n'a pas les moyens humains suffisants pour les maintenir, auquel cas des communautés d'utilisateurs-développeurs se les réapproprient parfois.

Lorsqu'un logiciel communautaire est pressenti pour répondre à un besoin spécifique pour un État, l'intégration requiert la plupart du temps de faire appel à des services de développement externes, c'est-à-dire des entreprises capables de répondre à un marché public en modifiant et adaptant le code libre ou open source issu de ces communautés, en fonction du cahier des charges du donneur d'ordre. Cependant, dans la configuration d'un marché libéralisé, l'État en vient à placer sur le même plan concurrentiel les produits issus des multinationales et les communs numériques issus de structures mixtes dont le modèle économique est non seulement différent, mais aussi beaucoup plus fragile. Cette mixité se construit d'un côté avec des petites entreprises ou start-up fournissant du développement sur la base de contrats avec l'État, et de l'autre côté, avec l'effort communautaire, mené par des collectifs, souvent bénévoles, ou bien construit sur du temps humain libéré par d'autres entreprises, sans contrepartie financière.

La question est donc de savoir comment maintenir le vivier libre ou open source dans cette configuration, et comment assurer le renouvellement de cette ressource face à la concurrence induite par la recherche de souveraineté. Il est important de ne pas considérer le code libre ou open source comme une ressource "commune" à épuiser dans le système néolibéral, mais plutôt de réévaluer une politique des communs qui soit démocratique et non productiviste.

Sources :

• Ceruzzi, P. E. (2003). A History of Modern Computing. MIT Press.

• Institut Mines Télécom (2023). Souveraineté numérique : enjeux et perspectives.

• Eghbal, N. (2017). Roads and Bridges: The Unseen Labor Behind Our Digital Infrastructure. Ford Foundation.

• Caffentzis, G. (2022). The Commons: An Alternative to Capitalism and the State? In The Wealth of the Commons: A World Beyond Market and State (pp. 31-41). Levellers Press.

• Casilli, A. A. (2019). En attendant les robots: enquête sur le travail du clic. Seuil.

• Hodgson, G. M. (2024). Public Money for Public Code: A Campaign for Software Freedom. Free Software Foundation Europe.

• Sawers, P. (2023). Element changes its open-source Matrix server’s license to AGPL. VentureBeat.

• Stiegler, B. (2015). L’emploi est mort, vive le travail! Entretiens avec Ariel Kyrou. Fayard/Mille et une nuits.

• Williams, S., Stallman, R. M., & Masutti, C. (2010). Free as in Freedom 2.0: Richard Stallman’s Selected Essays. GNU Press.

• Dardot, P., & Laval, C. (2015). Commun: essai sur la révolution au XXIe siècle. La Découverte.

• Graeber, D. (2014). The Democracy Project: A History, a Crisis, a Movement. Spiegel & Grau.

• Leach, M. (2013). Beyond development: a political manifesto. Routledge.

• Guichoux, J. (2016). Les mouvements des places: vers une démocratie réelle?. Éditions du Croquant.

• Crétois, T. (2017). L’intérêt général, expression de l’administration et du pouvoir. In L’intérêt général (pp. 11-26). La Documentation française.

• Michel, S., & Lamarche, T. (2024). L’université, un secteur productif comme les autres? Les effets pervers de la stratégie de mise en concurrence. Éditions de la Maison des sciences de l’homme.

• Shulz, T. (2021). The Partner State: A New Framework for 21st Century Governance. Commons Transition.

• Bollier, D. (2014). Think Like a Commoner: A Short Introduction to the Life of the Commons. New Society Publishers.

• Pénigaud de Mourgues, A. (2017). Jean-Jacques Rousseau et la question de l’intérêt général. In L’intérêt général (pp. 27-42). La Documentation française.

• Sauvêtre, P. (2022). Communs et communisation. Les prairies ordinaires.

Source de l'article :

Laviedesidees.fr

Cet article a été écrit avec un combo IA + bon sens humain.

Parce que l’un sans l’autre, c’est souvent foireux !

Publié le par Technifree

Article rédigé en partie avec l'aide de Mistral AI.

En parler sur le forum